人工智能一直是人类从进入信息时代后最热门的讨论题,两年前在谷歌旗下人工智能研究企业Deepmind研发的围棋AI,在陆续战胜李世石和柯洁两位顶级职业围棋选手后,带起了一轮围棋AI的研究热潮,腾讯等科技企业也陆续折腾了不少人机或机器对战赛事,那么象棋之类的AI出现只是时间问题了。

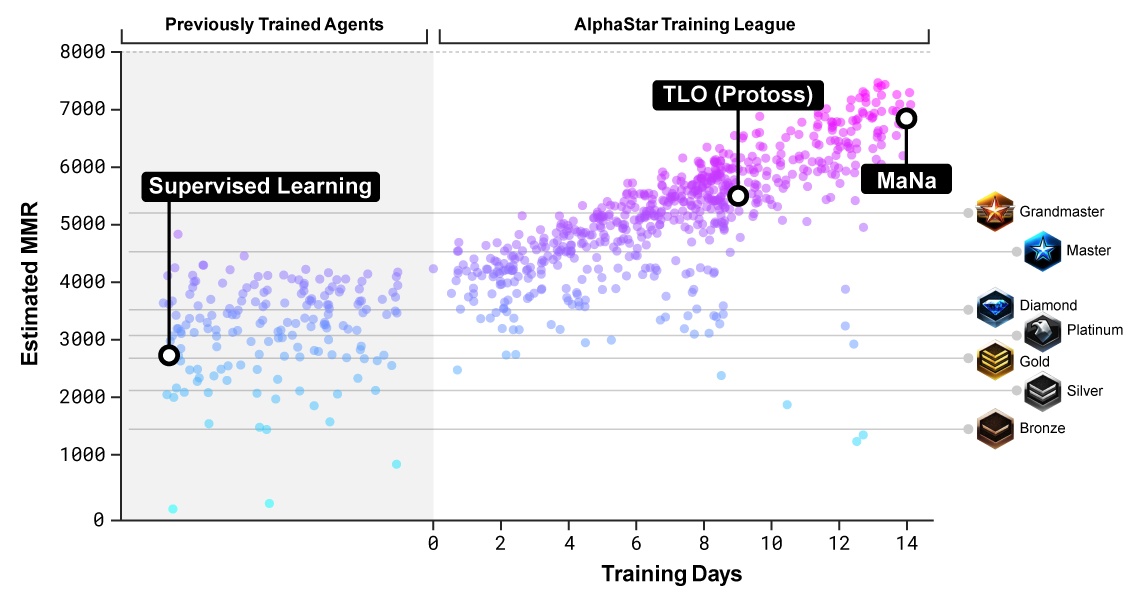

1月24日,Deepmind在官网了Youtube发表了旗下最新科技AlphaStar,并且在知名电竞游戏《星际争霸2》中以两个5:0战胜了两位世界排名前50的职业选手——液体[Team Liquid]的MaNa和TLO,但在随后的网上直播中人类扳回一城,而AlphaStar将在2月15日挑战WSC去年的总冠军Serral。

对于人类来说,是游戏复杂还是下棋复杂?这两者看起来完全不是一个时代的休闲娱乐竞技项目。众所周知星际玩家不需要视力,由于游戏存在战争迷雾,无法完全看到对方的爆兵和行动,而且存在多变的规则、地形等因素,还需要实时操作和随机应变,而棋盘战局则是透明公开的回合制,允许思考。主要挑战有博弈、不完整信息、长期规划、实时和巨大的行动空间,如果比类为棋盘,那么《星际争霸2》的可行动数为10的26次方级别。

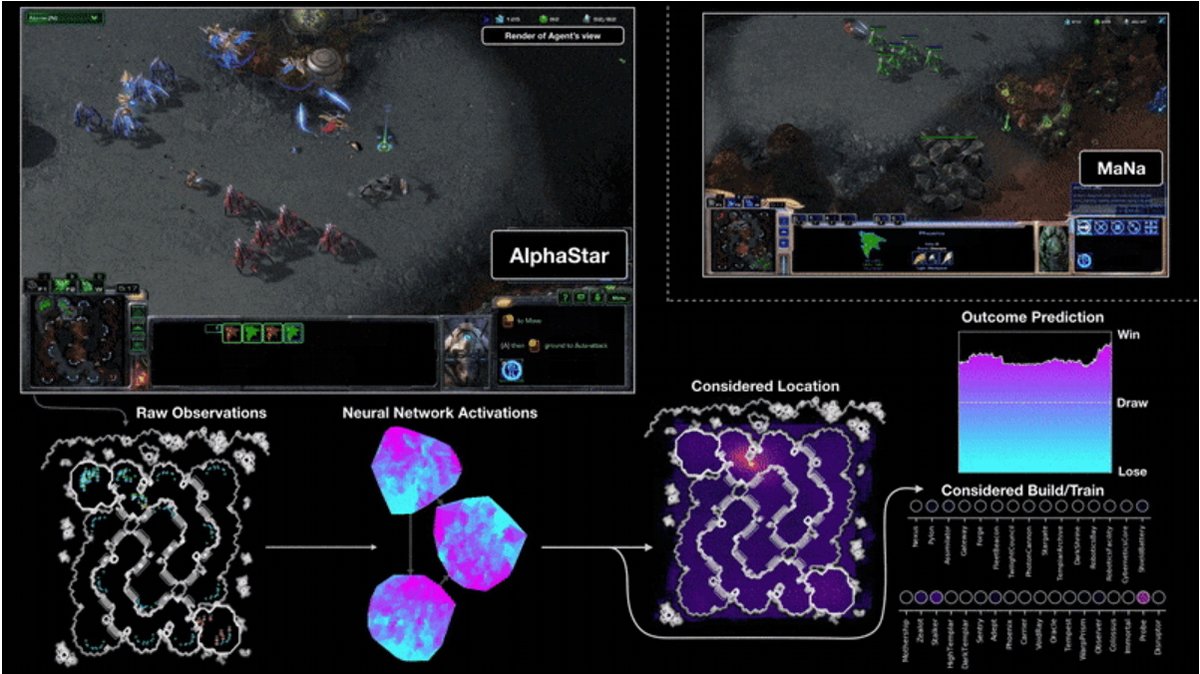

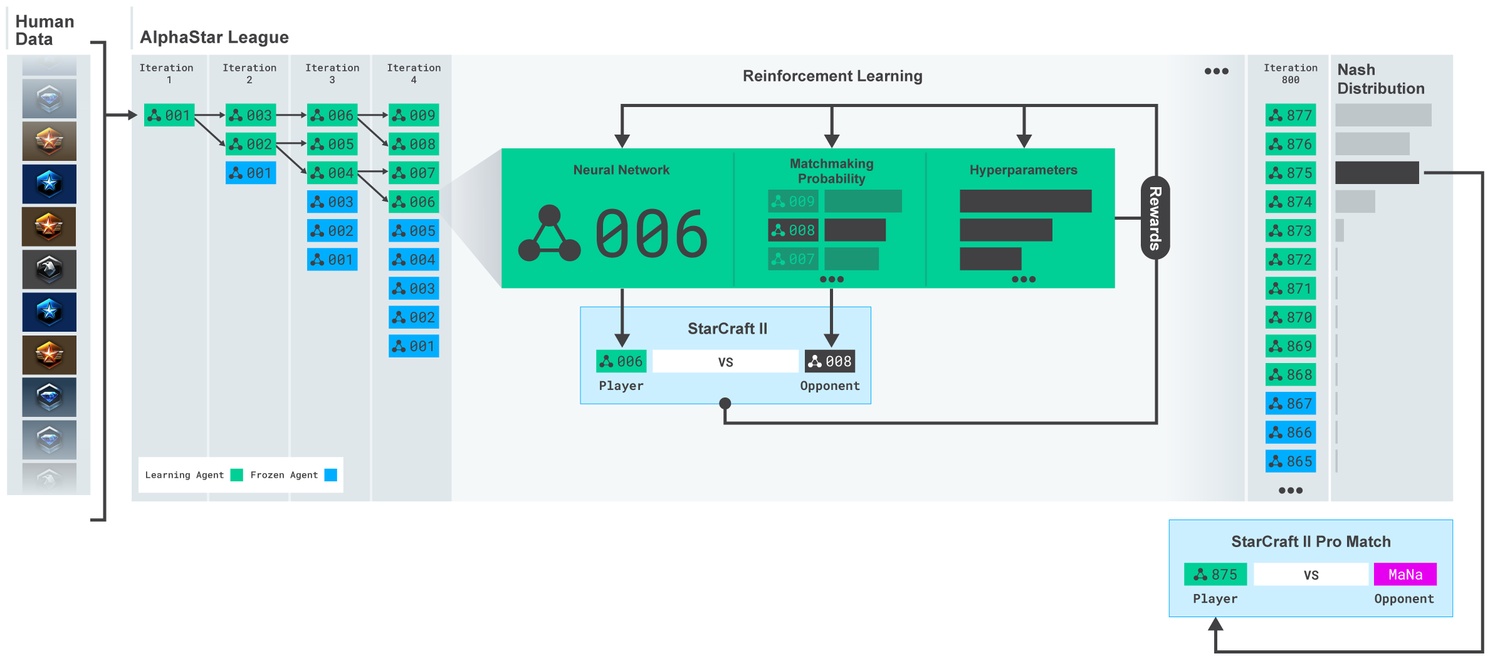

对于打电动的AI,不少院校已经在雅达利、超级马里奥、雷神之锤3、Dota2等游戏上有研究成果,但多数还处于bot级别,和普通玩家斗智斗勇的阶段。AlphaStar建立的目标就和AlphaGo类似,采用神经网络和深度学习技术使AI最终能挑战职业选手,其深度学习模式采用原始游戏数据输入,采用监督学习和强化学习模式。

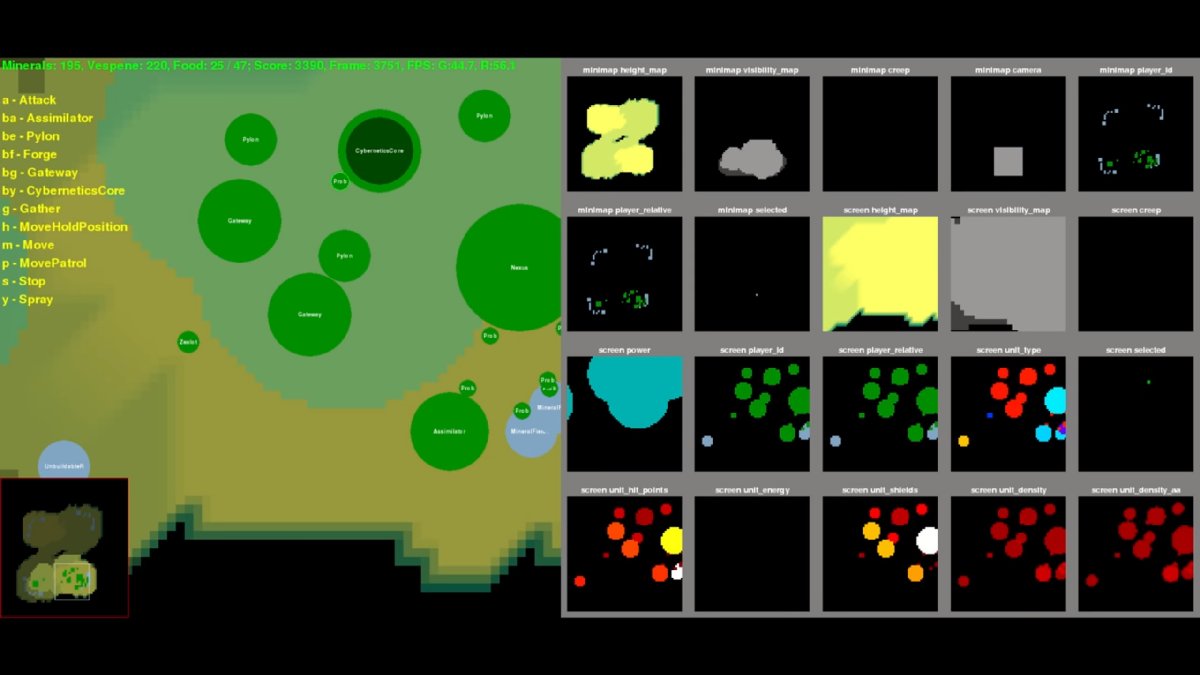

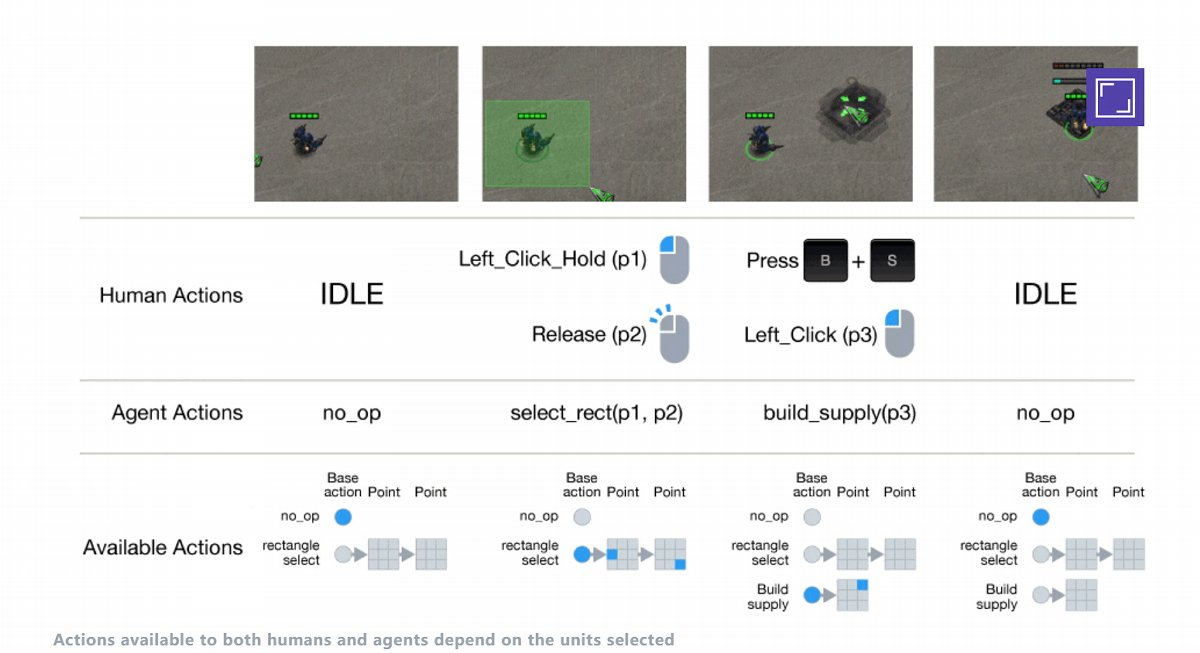

另一方面要解决的是命令输入,毕竟游戏的实时性无法像围棋那样通过下命令进行行动,而在机器观察和行动上,Deepmind采用的是和暴雪联合开发的开源机器操作接口PySC2,而观察、思考和行动被分为多个助手[Agent]模块。通过初步的监督学习,AlphaStar就战胜了游戏中的精英AI,达到玩家天梯中的黄金级别。

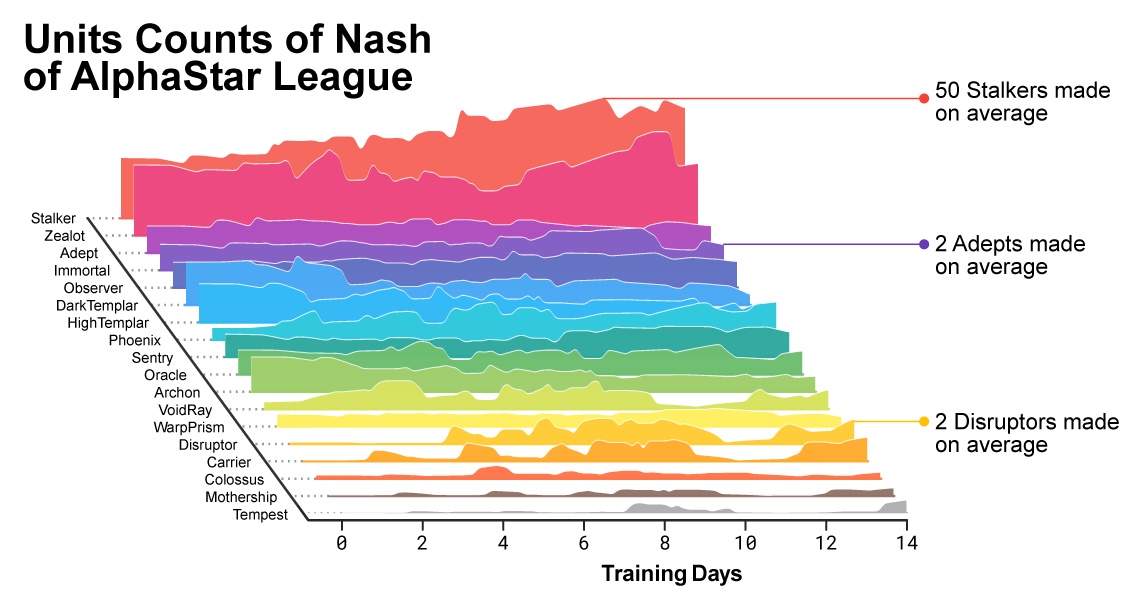

而在往后的深度学习中,Deepmind采用了谷歌最新的人工智能处理器TPU v3,每个Agent单元配备了16个TPU单元,在14天的深度学习中,每个Agent都灌输了200年时长的游戏回放进行训练。而最终会把有效的策略通过Nash分配技术集中在一台电脑上,也就意味着最终一个桌面PC级别的GPU就能和人类进行对抗。

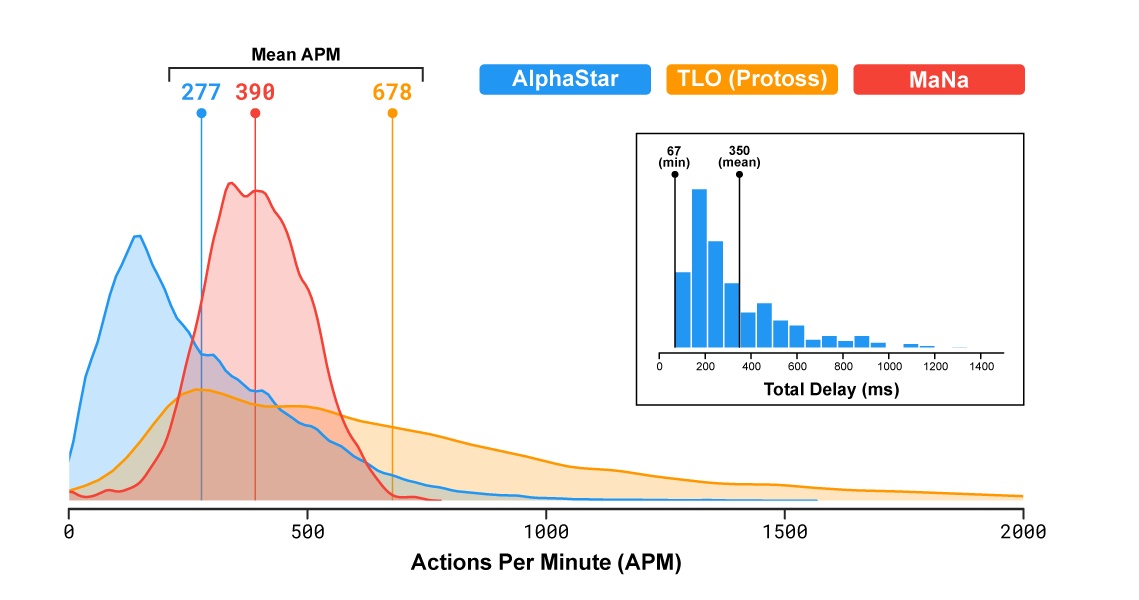

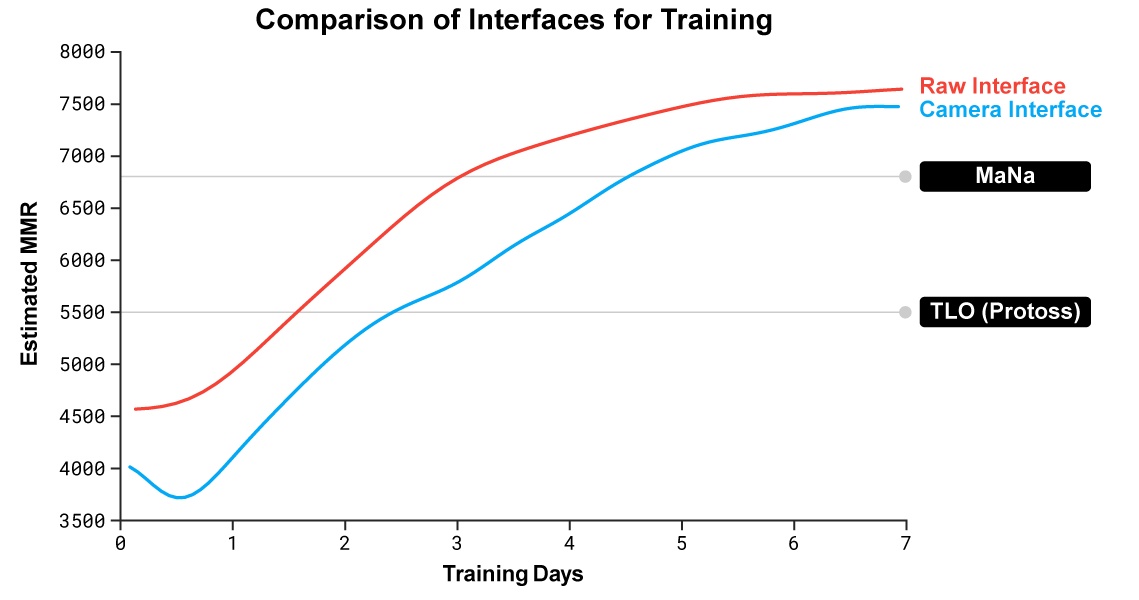

当然,从竞技角度来看,这次人机对战AI赢下的10局也并不是完全公平,因为AI获得的“图像”是整个游戏界面的原始输入[Raw Input]而不是显示器输出,AlphaStar不需要自己切换小地图进行战术分析和行动。虽然公平平等之类不是AI要解决的课题,不过AlphaStar相应也进行了图像识别的深度学习训练,其被称为Camera Agent,而直播的那一局正是因为AI第一次使用图像识别的原始版本而且未经过详细测试,因为视力不佳输给了职业选手,当然即使使用原始输入,也比星际2自带的开图AI公平不少,而且经过训练后,图像识别和原始界面两种方式的竞技强度相差不大。

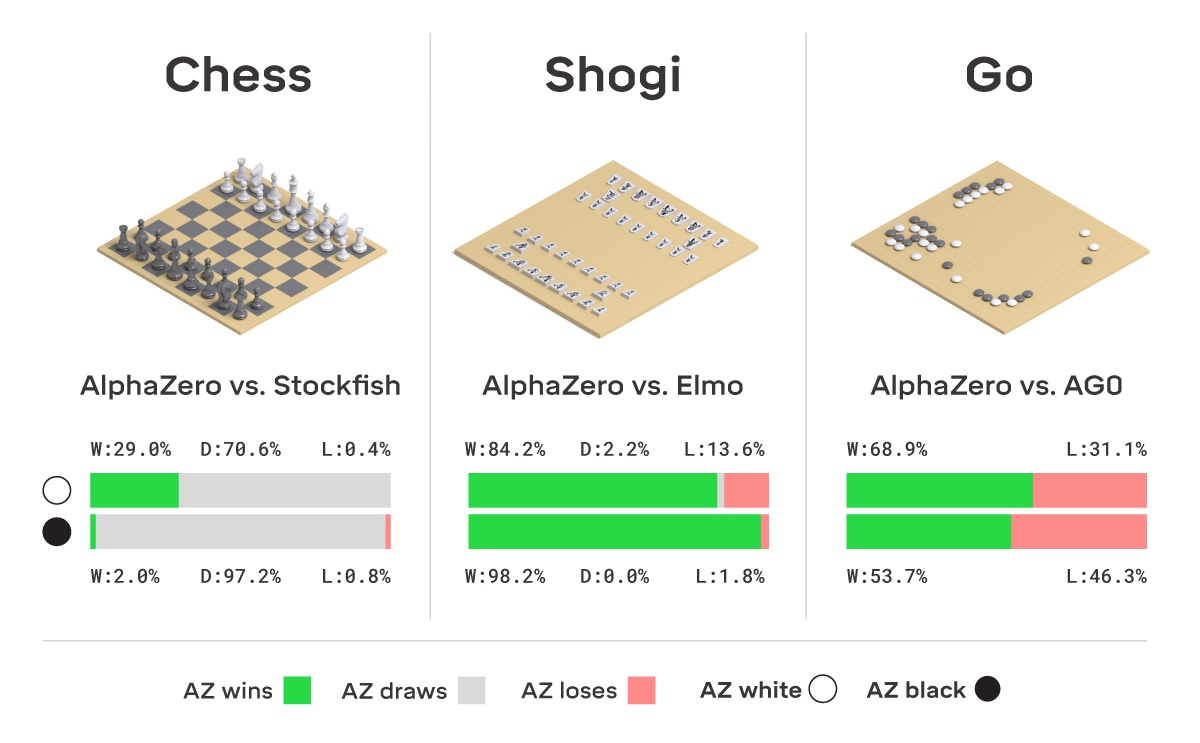

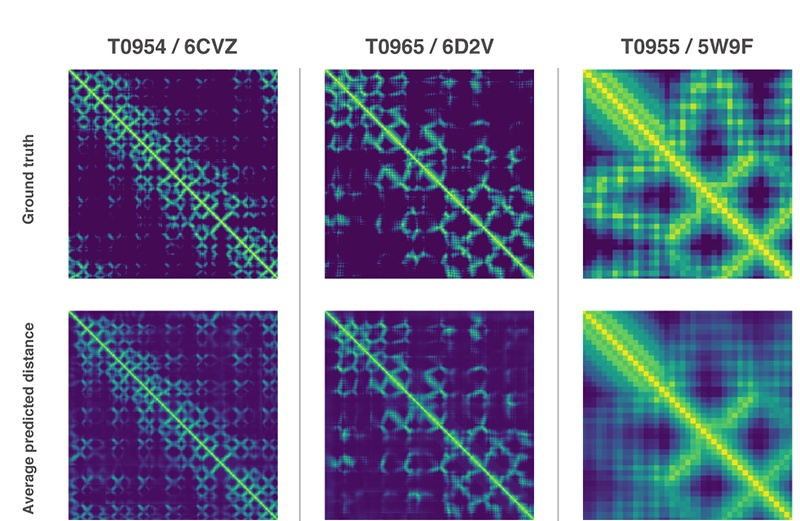

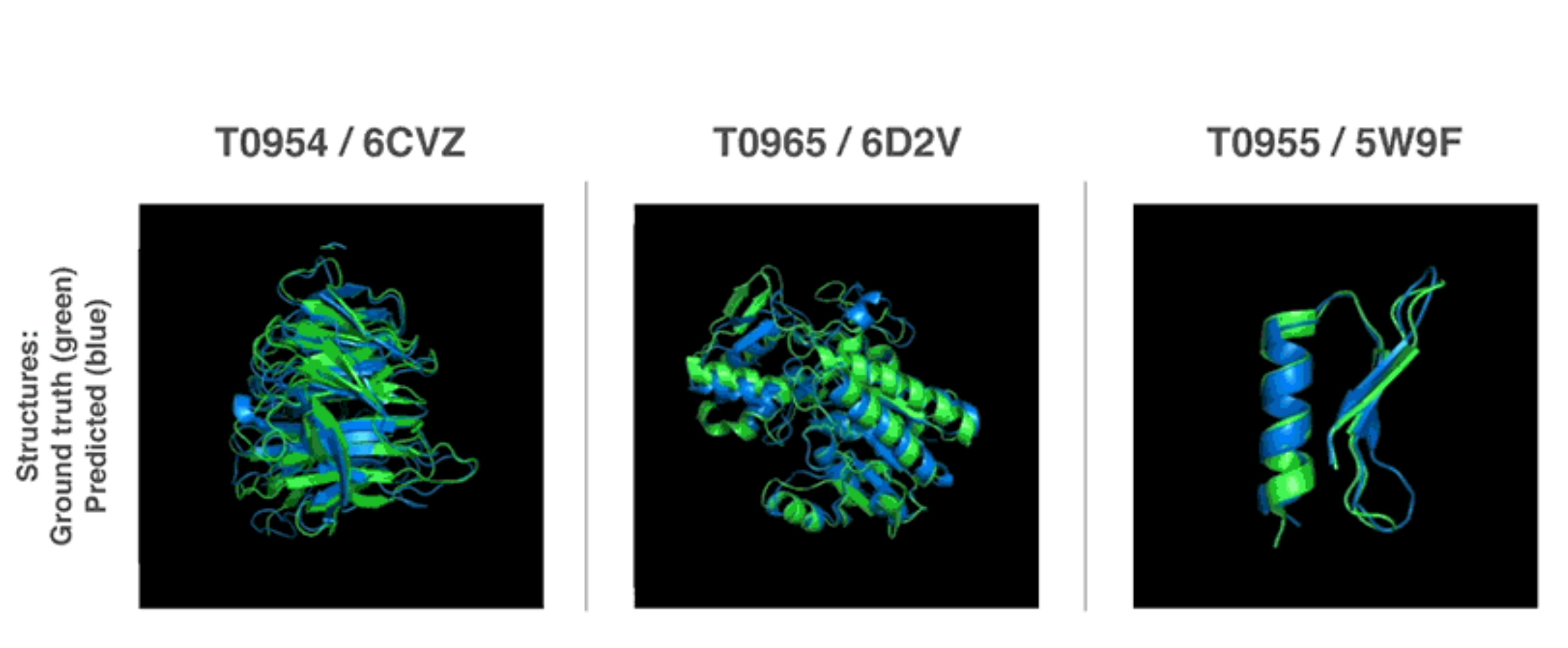

由于电竞在传统媒体上不一定会有围棋的热度,但作为Deepmind的技术成果展示,AlphaStar确实相较于AlphaGo又有了进步,无论是TPU硬件、深度学习时间等方面,它使用的硬件更少,学习速度也有了很大提升,对于推进人工智能技术和产业的进步也提供了指引。Deepmind团队同期还有两个大项目:AlphaZero[国际象棋和日本将棋AI]以及通过基因序列预测蛋白质3D结构的人工智能AlphaFold。

当然,这些东西或许离多数人的现实生活还比较遥远。在去年的12月5日,谷歌旗下的WayMo无人驾驶计程车开始在美国的凤凰城投入运营,给无人驾驶的商用和民用领域开启了新的篇章,对于某些不想买车的居民来说毫无疑问是非常期待的。

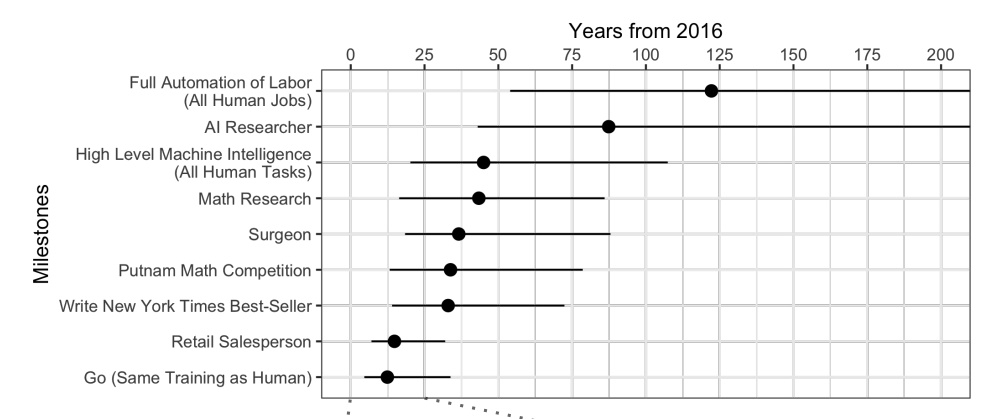

那是不是时候研讨AI取代人类这种杞人忧天了呢?从Deepmind的发展路线规划图来看,AlphaGo能像人类一样读懂棋谱至少也要10年以后,而有能力胜任人类所有机械智力工作的AI,至少也要40年后才能出现,而完全胜任人类工作的AI则是一个世纪之后,那么取代的问题就不用现在活着的人担心了,而如果有幸活到那个时候,还能有球型关节女仆给养老伺候,岂不美哉。

京公网安备 11011402011520号

京公网安备 11011402011520号